![图片[1]-【AI换脸】DeepFaceLab猫之汉化DeepFaceLab双12版 整合DML+CUDA-云端汇ZAL](https://www.yunduanzz.com/wp-content/uploads/2025/04/20250402122352238-02.png)

DeepFaceLab 是一种利用深度学习识别来交换图片和视频中的人脸的工具。即面部替换和深度伪造工具,这种技术在特定的场合下可以做出非常逼真自然的换脸视频。而 DeepFaceLab 是众多软件中,安装最简单,使用最方便,更新最快的一款软件。

功能特性

- 安装方便,环境依赖几乎为零,下载打包 app 解压即可运行(最大优势)

- 添加了很多新的模型

- 新架构,易于模型实验

- 人脸图片使用 JPG 保存,节省空间提高效率

- CPU 模式,第 8 代 Intel 核心能够在 2 天内完成 H64 模型的训练。

- 全新的预览窗口,便于观察。

- 并行提取

- 并行转换

- 所有阶段都可以使用 DEBUG 选项

- 支持 MTCNN,DLIBCNN,S3FD 等多种提取器

- 支持手动提取,更精确的脸部区域,更好的结果。

GitHubt地t址l : https://github.com/iperov/DeepFaceLab.git

![图片[2]-【AI换脸】DeepFaceLab猫之汉化DeepFaceLab双12版 整合DML+CUDA-云端汇ZAL](https://www.yunduanzz.com/wp-content/uploads/2025/04/20250402122351621-01.png)

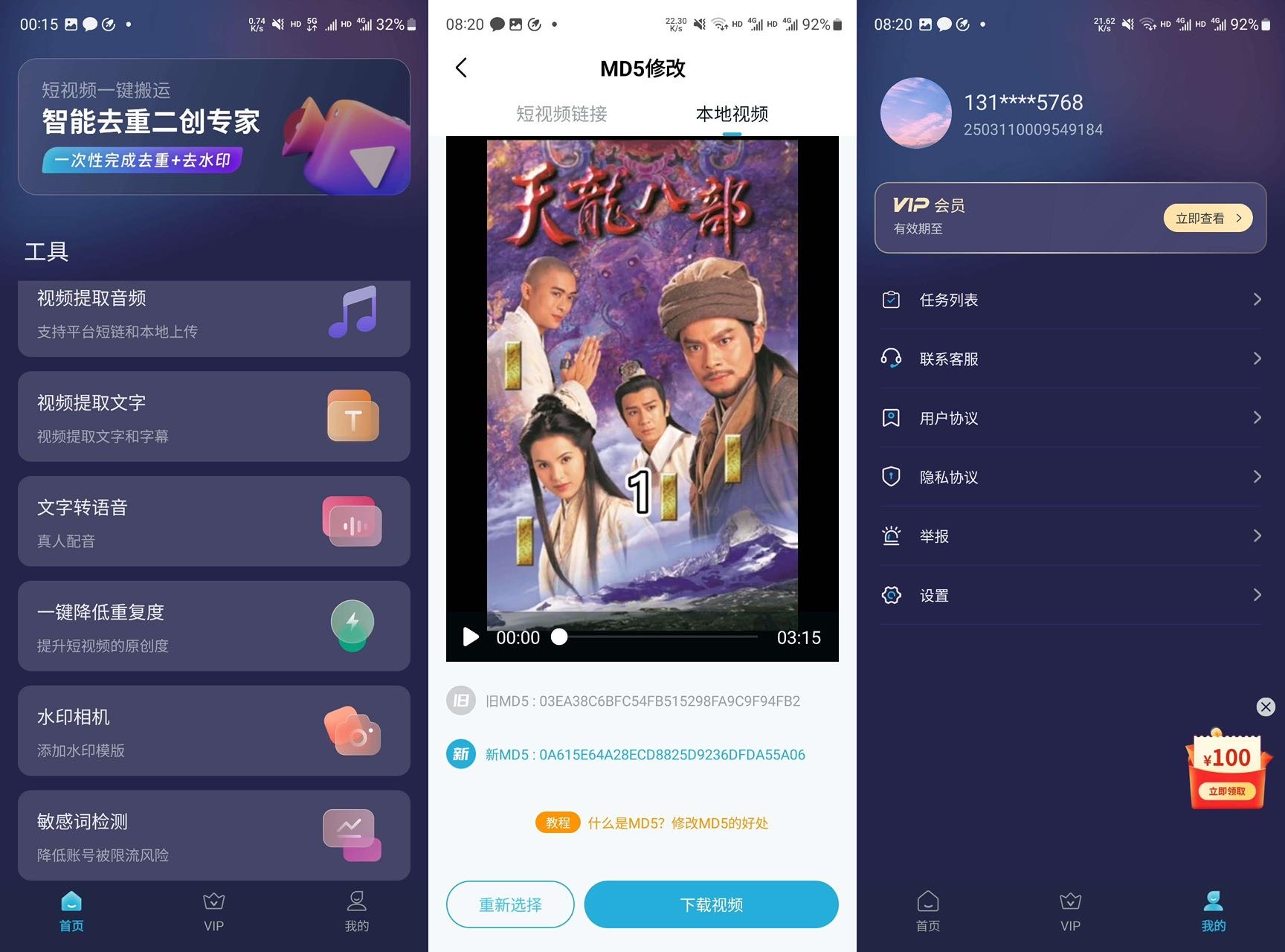

下载安装

具体的下载安装各方面的文章请参考上面的网站,下面主要介绍几个问题。

预编译好的Windows版本

原作者提供了预编译好的Windows版本,并且告诉我们依赖库都有了,只需要自己去安装nVidia的驱动。

并且还贴心的准备了使用GPU和CPU版本, 可以从MEGA下载:

https://mega.nz/#F!b9MzCK4B!zEAG9txu7uaRUjXz9PtBqg

编译的版本大概分这几类:

DeepFaceLabCUDA9.2SSE – NVIDIA显卡最高支持到GTX1080和任何64位CPU

DeepFaceLabCUDA10.1AVX – NVIDIA显卡最高支持到RTX和支持AVX指令集的CPU

DeepFaceLabOpenCLSSE – AMD/IntelHD显卡和任何64位CPU

硬件要求

系统: Win7, Win10

显卡:GTX 1060以上效果较好,需要安装windows 版本的VS2015,CUDA9.0和CuDNN7.0.5

优点:基于Faceswap定制的bat处理批版本,硬件要求低,2G显存就可以跑,支持手动截取人脸、集成所需要的

素材和库文件,功能强大

缺点:复杂、处理批较多,脸部数据不能和其他deepfakes通用,需要重新截取

总结:适合有一定编程基础、追求效率高的用户

下载方式:本页下载链接即可下载

————————————————

不同的模型与参数(补充)

训练模型

H64 (2GB +):分辨率为64的半脸模型,适合2-3GB显存,当然质量也较低。

H128 (3GB +):分辨率为128的半脸模型,适合3-4GB显存,半脸模型某些光线条件下会很糟糕。

DF (5GB +):分辨率为128的全脸模型,适合5GB以上显存,有条件就可以用这个。

LIAEF128 (5GB +):和DF一样,只从源到目标变形,有些时候会很怪,那么还是选DF吧。

SAE (512MB +):最新最好最弹性的模型,包括其它所有模型,512MB-24GB显存都可用,参数多。

训练参数

H64,H128 模型的参数:

Use lightweight autoencoder? (Y / n,:? Help skip: n):

选择一个简版的模型,如果你的显存小于4GB,这个选项就很必要。

H64, H128, DF, LIAEF128 模型的参数:

Use pixel loss? (Y / n,:? Help skip: n / default):

更容易提升细节质量和去除图像颤动,请在训练至少20000次以后再打开这个选项(有模型崩溃风险)。

SAE 模型的参数:

Resolution (64-256:? Help skip: 128):分辨率从64到256,16的倍数,愈大越清晰,训练也需要越长。

Half or Full face? (H / f,:? Help skip: f):半脸还是全脸。

Learn mask? (Y / n,:? Help skip: y):学习的遮罩,呃,懒得翻译了,用它就对了。

Optimizer mode? (1,2,3:? Help skip:% d):N卡的神经网络优化模式,越大需要内存越多,也会更慢。

AE architecture (df, liae, vg:? Help skip: df):神经网络结构,缺省df。

AutoEncoder dims (128-1024:? Help skip:% d):网络维度,越多越好(但是内存得够啊)。

Encoder dims per channel (21-85:? Help skip:% d):也是越多越好(但是内存得够啊)根据显卡配置吧。

Decoder dims per channel (11-85:? Help skip:% d):同上(decoder的维度)。

Remove gray border? (Y / n,:? Help skip: n):去掉灰边,我记得已经没有这个选项了啊???

Use CA weights? (Y / n,:? Help skip:% s):是否使用卷积感知权重,提高模型精度,初始化要点时间。

Use multiscale decoder? (Y / n,:? Help skip: n):是否使用多路转换decoder,获得更高精度。

Use pixel loss? (Y / n,:? Help skip: n / default):更容易提升细节质量和去除图像颤动,请在训练难以提升质量以后再打开这个选项(有模型崩溃风险)。

Face style power (0.0 … 100.0:? Help skip:% 1f.):脸部特征影响值,加速转换学习的脸部特征(有模型崩溃风险)。搞不懂先别开哦。

Background style power (0.0 … 100.0:? Help skip:% 1f.):背景特征影响值,加速转换学习的脸部特征(有模型崩溃风险)。搞不懂先别开哦。

Apply random color transfer to src faceset? (Y / n,:? Help skip:% s):源脸随机颜色转换,比上面两个更加精确。需要学习更多的源脸。

Pretrain the model? (Y / n,:? Help skip: n):预先训练模型(已经包含了的许多不同的人脸模型)

转换参数

通常不变的参数:

Choose mode: (4) seamless

Seamless hist match? : y

Hist match threshold: 255

Mask mode: (1) learned,

下面的参数就值得调整了:

Choose erode mask modifier [-200…200] (skip:0) :决定缩小多少目标遮罩(值<0则是扩展遮罩)

Choose blur mask modifier [-200…200] (skip:0) :决定平滑目标遮罩的值。

Choose output face scale modifier [-50…50] (skip:0) : 源脸放大还是缩小(先试试0,再根据实际情况)

Apply color transfer to predicted face? Choose mode ( rct/lct skip:None ) : 两种都试试吧。

Degrade color power of final image [0…100] (skip:0) : 降低源脸的色彩值,根据实际情况设置。

————————————————

感谢您的来访,获取更多精彩文章请收藏本站。

1. 资源都是经过站长或作者收集测试修改后发布分享。转载请在文内以超链形式注明出处,谢谢合作!

2. 本站除原创内容,其余所有内容均收集自互联网,仅限用于学习和研究目的,本站不对其内容的合法性承担任何责任。如有版权内容,请通知我们或作者删除,其版权均归原作者所有,本站虽力求保存原有版权信息,但因众多资源经多次转载,已无法确定其真实来源,或已将原有信息丢失,所以敬请原作者谅解!

3. 本站用户所发布的一切资源内容不代表本站立场,并不代表本站赞同其观点和对其真实性负责,若您对本站所载资源作品版权归属存有异议,请留言附说明联系邮箱,我们将在第一时间予以处理 ,同时向您表示歉意!为尊重作者版权,请购买原版作品,支持您喜欢的作者,谢谢!

4. 本站一律禁止以任何方式发布或转载任何违法的相关信息,访客如有发现请立即向站长举报;本站资源文件大多存储在云盘,如发现链接或图片失效,请联系作者或站长及时更新。

暂无评论内容